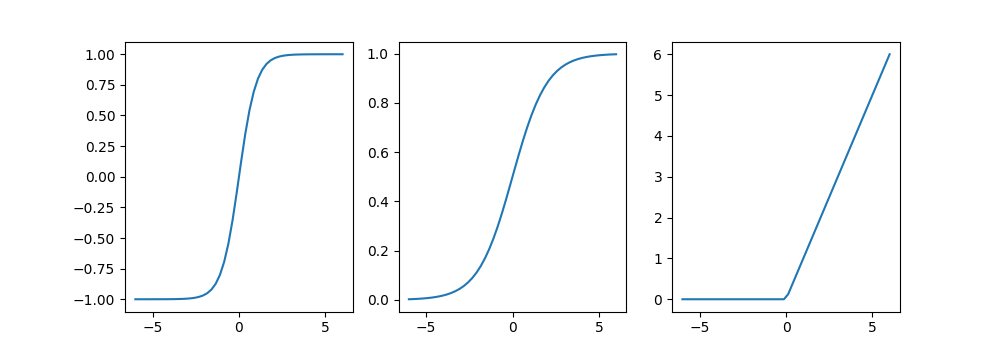

Funciones de activación para la capa oculta#

Ultima modificación: 2023-03-11 | YouTube

Son las funciones que se aplican a la entrada neta de las capas ocultas.

Son responsables de la capacidad no lineal del MLP.

Son funciones monotonicas crecientes.

Las funciones de activación implementadas en sklearn son:

'tanh': g(u) = \tanh(u)'logistic': 1 / [1 + \exp(-x)]'relu': \max (0, x)

[2]:

def fig1():

import matplotlib.pyplot as plt

import numpy as np

x = np.linspace(-6, 6)

plt.figure(figsize=(10, 3.5))

plt.subplot(1, 3, 1)

plt.plot(x, np.tanh(x))

plt.subplot(1, 3, 2)

plt.plot(x, 1 / (1 + np.exp(-x)))

plt.subplot(1, 3, 3)

plt.plot(x, np.where(x < 0, 0, x))

plt.savefig('assets/fig1.png')

plt.close()

## fig1()